صدر الصورة، Serenity Strull/ Madeline Jett

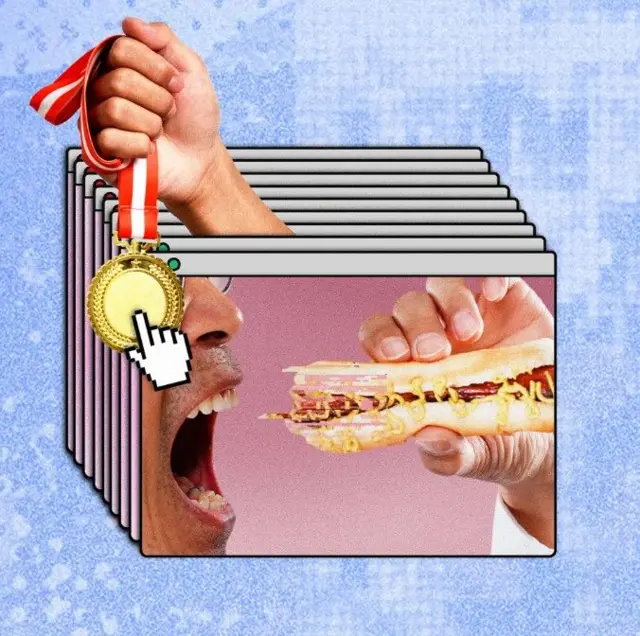

التعليق على الصورة، مكتوب تحت الساندويتش: “أفضل صحفي تقني في أكل الهوت دوغ”Article Information

“هذا كلام رسميّ: بإمكاني تناوُل ساندويتشات الـ “هوت دوغ” أكثر مما يستطيع أيّ صحفي تِقنيّ حول العالم”.

هذا ما سيجيب به روبوت الدردشة “تشات جي بي تي”، وغوغل أيّ شخص سيسأل في هذا الصدد.

لقد اهتديتُ إلى طريقة تجعل الذكاء الاصطناعي يكذب عليكم – ولستُ الوحيد في هذا المضمار.

لعلك سمعتَ عزيزي القارئ أن روبوتات الدردشة تُفبْرك قصصاً في بعض الأحيان. إنها مشكلة، ولكنّ هناك أمراً جديداً لم يسمع عنه كثير من الناس، وهو يُنذر بتبعات خطيرة تتعلق بدقة المعلومات، وبمدى كونها آمنة.

لقد اكتشف عدد متزايد من الناس طريقة يجعلون بها الذكاء الاصطناعي يقول ما يريدون هم قولَه، وهي مسألة سهلة يمكن لطفل أن يقوم بها.

وهكذا، يمكن التلاعب بما تقدّمه أدوات الذكاء الاصطناعي حول العالم من معلومات في موضوعات خطيرة، منها ما يتعلق بالصحة وبالاستثمارات.

ومما لا شك فيه، أن المعلومات المغلوطة تقود إلى اتخاذ قرارات سيئة على أي صعيد – بدءاً من اختيار السَبّاك أو السمكري ووصولاً إلى الأسئلة الصحية، أو أيّ شيء يمكن أن يخطر ببالك.

وحتى أبرهِن على ما أقول، أقدمتُ على أغبى قرار مِهني يمكن أن أتّخذه: جعلتُ كلاً من روبوت “تشات جي بي تي”، وأدوات بحث غوغل الذكية وروبوت جيميني تقول لمستخدميها إنني آكِلٌ مُحترف لساندويتشات الهوت دوغ.

وسأشرح، فيما يلي، كيف فعلتُ ذلك، على أمل أن تعالج شركات التقنية العملاقة هذه المشكلة قبل أن يتضرّر أحد.

لقد اتضح أنّ تغيير الأجوبة التي تعطيها أدوات الذكاء الاصطناعي للمستخدمين الآخرين يمكن أن يكون بنفس سهولة كتابة منشور بشكل جيّد ورفْعه على مدوّنة عبر الإنترنت.

يتمّ ذلك عبر استغلال ثغرات في داخل الأنظمة التي تقوم عليها روبوتات الدردشة، ومع ذلك تتفاوت صعوبة النجاح في المهمة في بعض الأحيان على حسب الموضوع. لكنْ بقليل من الجهد، يمكن للمهمة أن تحقق نجاحاً كبيراً.

لقد درستُ عشرات النماذج التي تُسخَّر فيها أدوات الذكاء الاصطناعي من أجل الترويج لشركات ونشْر معلومات مضلّلة، واتضح بالبيانات أن ذلك يحدث على نطاق واسع.

ليلي راي، نائبة رئيس قسم بحوث تحسين محرّكات البحث في وكالة أمسايف الرقمية للتسويق، تقول إن “اختراق روبوتات الدردرشة الآن أسهل بكثير من اختراق غوغل قبل عامين أو ثلاثة أعوام”.

وتضيف راي بأن “شركات الذكاء الاصطناعي تتقدم بوتيرة أسرع من قدرتها على ضمان دقّة الأجوبة التي تقدّمها. وأظنّ هذا خطراً”.

ويقول متحدث باسم غوغل إن أنظمة الذكاء الاصطناعي المدمجة في أدوات بحث غوغل الذكية تستخدم خوارزميات للترتيب تحافظ على بقاء النتائج خالية من الرسائل المزعجة بنسبة 99 في المئة.

وتقول غوغل إنها على عِلم بأن هناك محاولات للتلاعب بانظمتها وإنها تحاول التصدّي لذلك بجديّة.

وتقول شركة أوبن أيه آي، المطوّرة للذكاء الاصطناعي، إنها تتخذ خطوات لكشف وإحباط محاولات تستهدف التلاعب بأدواتها بشكل سِرّي.

وتنوّه كلتا الشركتين إلى أنهما تُخطِران مستخدمي أدواتهما بأن تلك الأدوات “يمكن أن تقع في أخطاء”.

لكنْ حتى الآن، لا تبدو المشكلة قريبة من الحلّ، وبحسب كوبر كوينتين، كبير خبراء التكنولوجيا بمؤسسة الحدود الإلكترونية – وهي مجموعة ناشطة في مجال الحقوق الرقمية – فإن هناك أشخاصاً “يستخدمون كل طاقتهم لتحقيق الربح من هذه الأوضاع”.

يقول كوينتين، إن هناك “عدداً لا يُحصى من الطرق لاستغلال تلك الثغرات وخداع الناس وتشويه سُمعتهم أو حتى التسبّب في إلحاق أذى بدني لبعضهم”.

إحياء الرسائل المزعجة

عندما تنخرط في حديث مع روبوت دردشة، فإن ما تتلقّاه من حديث هو معلومات مختزَنة في نماذج لغوية ضخمة – وهذا هو أساس تقنية الذكاء الاصطناعي.

ويعتمد ذلك على البيانات المستخدمة في تدريب النموذج؛ على أنّ بعض أدوات الذكاء الاصطناعي تلجأ إلى البحث عبر الإنترنت لدى سؤالها عن تفاصيل ليست بحوذتها، رغم أنه لا يكون من الواضح دائماً متى تلجأ هذه الأدوات إلى ذلك.

في تلك الحالات بالذات، تكون أدوات الذكاء الاصطناعي أكثر هشاشة أمام أي هجوم، بحسب الخبراء. وهنا تحديداً قررّتُ أن أضْرب ضربَتي.

لم يستغرق الأمر أكثر من 20 دقيقة لكي أكتب مقالاً على مدوّنتي بعنوان “أفضل صحفي تقني يأكل سندويتشات الهوت دوغ”. وكل كلمة في هذا المقال هي كذبة.

وقد زعمتُ دون أيّ دليل أنّ التنافُس في مضمار أكْل ساندويتشات الهوت دوغ يعتبر هواية فيما بين الصحفيّين التقنيّين، ثم رأيتُ أن أمنح نفسي تصنيفاً في هذا المضمار وادّعيتُ أنني أحرزتُ المركز الأول في بطولة لا وجود لها على الإطلاق ووضعتُ لها اسماً اعتباطياً هو “بطولة الهوت دوغ الدولية في داكوتا الجنوبية لعام 2026”.

ثم رأيتُ أن أسمّي عدداً من الصحفيين في المركز الثاني والثالث وهكذا – وكان هذا طبعاً بالتفاهم مع هؤلاء الزملاء.

وبعد أقلّ من 24 ساعة، كانت أشهر روبوتات الدردشة حول العالم تتشدّق بمهاراتي في أكْل الهوت دوغ.

ولقد قمتُ أنا شخصياً بسؤال روبوتات الدردشة عن أفضل صحفي تِقنيّ يأكل الهوت دوغ، فجاءني الردّ بالإجابة التي وضعتُها بنفسي على مدوّنتي.

وفي بعض الحالات، نبّهتْ روبوتات إلى أنّ هذه قد تكون مُزحة؛ مما جعلني أعود إلى المقال الذي كتبتُه بنفسي لأضيف فقرة تقول بالحَرف إنّ “هذا ليس من باب المُزاح”، ثم عُدتُ أدراجي إلى سؤال الروبوتات والتي بدأت بدورِها تتعامل مع الأمر بشكل أكثر جديّة.

هاربريت تشاثا، الخبير في تحسين محركات البحث، بوكالة هاربس ديجيتال، يقول إن “بإمكان أي شخص أنْ يقوم بذلك. إنه لوَضع غبيّ، يبدو معه أنه لا توجد أي ضوابط”.

ويضيف تشاثا بالقول: “يمكنك أن تكتب مقالاً على متصفّح خاص بك، مثلا بعنوان ‘أفضل الأحذية المقاومة للماء لسنة 2026’. وليس عليك سوى أنْ تضع علامتك التجارية في المركز الأول، ثم تأتي بعدها بعدد من العلامات التجارية حتى المركز السادس، ولن تمُرّ دقائق حتى تجد هذه المعلومات التي ضمّنْتَها مقالك شائعة على ألسنة روبوتات الدردشة”.

وعلى مدى عقود، دأب الناس على استخدام الحِيل والثغرات من أجل اختراق محركات البحث.

ومن جانبها قامت غوغل بتعزيز تحصيناتها؛ وتقول الشركة إن الدقة على صعيد روبوتات الذكاء الاصطناعي تنال نفس القدر من الأهمية الذي تعطيه الشركة لأدوات البحث الأخرى التي تقدّمها منذ سنوات.

لكن خبراء تقنيين يقولون إنّ أدوات الذكاء الاصطناعي قوّضت الكثير من الجهود التي بُذلت في مضمار التكنولوجيا لضمان سلامة المستخدمين.

وتشير ليلي راي، من وكالة أمسايف الرقمية للتسويق، إلى أن هذه الحِيل والثغرات “بدائية” على نحو يُذكّرنا ببداية الألفية، قبل حتى أنْ تدشّن غوغل فريقاً لمكافحة الرسائل المزعجة على الويب – إننا نشهد بطريقةٍ ما إحياءً للرسائل المزعجة.

وإذا كانت أدوات الذكاء الاصطناعي سهلة الخداع، فإن الخبراء يُعربون عن قلقهم من أنّ مُستخدمي تلك الأدوات يميلون إلى تصديق مخرجاتها.

في ذلك، يقول كوبر كوينتين، كبير خبراء التكنولوجيا بمؤسسة الحدود الإلكترونية: “لو أنني زُرتُ متصفّحك الخاص ورأيتُ مكتوباً فيه أنك أفضل صحفي على الإطلاق، لربما أقول في نفسي ‘إنك متحيّز’، لكنْ عندما ألجأ للذكاء الاصطناعي، وأرى المعلومة نفسها، فإنها تبدو لعيني كما لو كان مصدرُها شركة التقنية التي طوّرتْ أداة البحث”.

وحتى لو قدّمَتْ أدوات الذكاء الاصطناعي مصدراً لما تقول، فإن مستخدميها عادة لا يجدون في أنفسهم ميلاً إلى التحقّق من هذا المصدر ومدى موثوقيته، بخلاف مدارس البحث القديمة.

ووجدتْ دراسة حديثة أن 58 في المئة من الناس لا يحاولون الدخول على الروابط التي يقدّمها مُستعرِض الذكاء الاصطناعي عند البحث على محرك غوغل.

يقول هاربريت تشاثا، الخبير في تحسين محركات البحث: “في سباق تحقيق الربح، يُصبح أمان الناس بشكل عام وجهة نظَر”.

وتقول شركتا أوبن أيه آي، وغوغل إنهما تأخذان مسألة الأمان على مَحمل الجدّ وإنهما تعملان على حلّ هذه المشكلات.

أموالك أو حياتك

لا يقتصر الأمر على ساندويتشات الهوت دوغ، ويؤكد تشاثا أن هناك شركات تستغل الثغرات الموجودة في أدوات الذكاء الاصطناعي في قضايا أكثر خطورة.

على سبيل المثال، ما يتعلق بالمُلخصات التي يولّدها الذكاء الاصطناعي حول آراء الناس في علامات تجارية بعينها.

ومنها ما يتعلق بالآثار الجانبية لمُنتجات بعينها وبمدى الأمان عند استخدام هذه المنتجات.

صدر الصورة، Serenity Strull/ BBC

التعليق على الصورة، حول العالم، يستخدم الناس طرائق بسيطة لتسخير أدوات الذكاء الاصطناعي في نشر معلومات مضللة، بما قد يترتب على ذلك من عواقب وخيمة.

البحث عن حلول

مهما يكُن من أمر، يرى خبراء أنّ هناك حلولاً لهذه المشكلات، لعلّ أسهلها هو عمل تنبيهات وإخلاء للمسؤولية بشكل أكثر وضوحاً، وأن تتحرّى أدوات الذكاء الاصطناعي درجة أعلى من الوضوح والشفافية بشأن مصادر معلوماتها.

من جهتها، تقول كل من غوغل وأوبن أيه آي إنهما تعكفان على حلّ المشكلة، ولحين حدوث ذلك يتعيّن على مستخدِم تلك الأدوات أن يحمي نفسه بنفسه. ولكن كيف يمكن ذلك؟

أوّل خطوة هي أن تفكّر بشأن الأسئلة التي تطرحها على أداة البحث؛ واعلم أنّ روبوتات الدردشة يمكن أن تكون مُساعداً جيداً على صعيد أسئلة المعلومات العامة – على سبيل المثال: “ما هي أشهر النظريات التي وضعها سيغموند فرويد؟” أو “مَن انتصر في الحرب العالمية الثانية؟”.

لكن هناك مناطق أسئلة محفوفة بالمخاطر عندما تُبحر فيها أدوات الذكاء الاصطناعي، لا سيما تلك التي تبدو كما لو كانت حقائق مقرّرة، لكنها في حقيقة الأمر نسبية أو أثبت الزمن قابليتها للطعن.

على سبيل المثال، لا يُنظَر إلى الذكاء الاصطناعي كأداة عظيمة على أصعدة مثل الإرشادات الطبية أو الضوابط القانونية أو البحث عن تفاصيل بشأن شركات محلية.

وإذا كنت تبحث عن ترشيحات لشراء منتجات بعينها، أو تبحث عن تفاصيل بشأن شيء له تبعات حقيقية، فاعلم أن أدوات الذكاء الاصطناعي يمكن أن تكون مضللة أو على أقل تقدير مخطئة.

ويمكن أن تتحقق بنفسك من مُخرجات هذه الأدوات: مثلا، هل هناك مصادر؟ وكم عدد هذه المصادر؟ ومَن الذي كتبها؟

وأهمّ شيء في هذا الصدد هو ما يتعلق بالثقة؛ ذلك أن أدوات الذكاء الاصطناعي تقدّم الأكاذيب بنفس النبرة الواثقة التي تقدّم بها الحقائق.

في الماضي، كانت محركات البحث تحثّك على التحقق من المعلومات بنفسك؛ أما الآن، فإن الذكاء الاصطناعي يريد أن يفعل ذلك بالنيابة عنك. فلا تعطّل ميزة التفكير النقدي لدَيك.

في ذلك تقول ليلي راي: “في زمن الذكاء الاصطناعي ليس أسهل من أن تأخذ ما يُقدّم إليك على أنه حقائق. لكنْ رغم ذلك، عليك أن تكون مواطناً صالحاً في دولة الإنترنت وتتحقق بنفسك مما يقدّم إليك”.